Em resumo, acredito que o Metaverso da Meta vá falhar. Não vou encher linguiça na minha introdução porque é muita coisa. Eu não falo isso por desprezo a Meta falo porque eu tenho conhecimento suficiente de programação além de ter contribuído para uma conhecida API para facilitar o processamento de palavras em redes neurais.

Não há definição específica de Metaverso

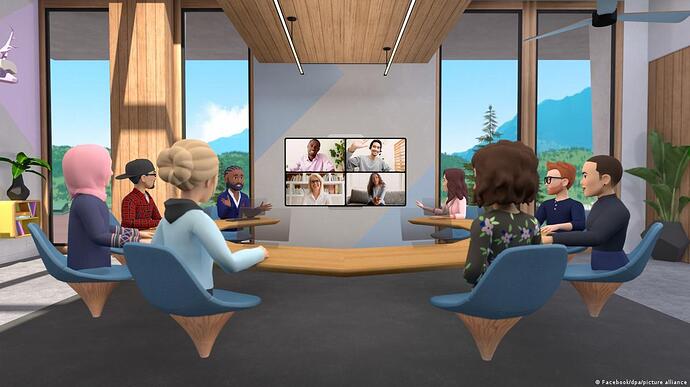

As pessoas e muitas vezes a própria imprensa exageram na expectativa do metaverso e isso vai contribuir para a falha do mesmo. Isso já aconteceu e será exemplificado mais abaixo. Ao meu ver é que a Meta está mostrando imagens de uma solução empresarial para fazer videoconferências usando Realidade Virtual (como o conceito em imagem abaixo).

No lado do usuário final, as pessoas querem um mundo virtual completamente interativo. Isto incentivou muitas pessoas a criarem cursos preparatórios para marketing no metaverso (bruh). Isto ficou mais evidente depois da ultima atualização sobre o Metaverso postado por Zuckerberg:

Como pode ver, o real estado do Metaverso depois de quase 1 ano após o anúncio é um autêntico Miitopia sem sombreadores. E isto não agradou aos fãs.

O mesmo aconteceu com o jogo Pokemon Go, onde seu anúncio gerou uma grande expectativa sobre o app (não hávia especificação técnica sobre o que é Pokemon Go). O jogo durou bem em seus primeiros anos. Eu joguei, você jogou. Mas o fato é que o jogo despencou sua base de usuários. Eu mesmo não vejo mais gente jogando o jogo. Isto se deve ao software não conseguir manter a expectativa de seu anúncio após o lançamento.

Especificações de hardware para servidores

A Intel já alertou, não é possível manter um metaverso em condiçoes atuais. Isso nós já sabemos. Mas POR QUE!? Bom, isso vai depender de como a Meta irá implementar sua renderização:

No servidor:

O dispositivo do usuário irá enviar dados dos movimentos do usuário como pose dos dedos, expressão facial para o servidor (Possivelmente uma imagem para melhor trabalho com AI. Isso permite que dados de seu rosto sejam vendidos).

O servidor então irá realizar a montagem em 3D do ambiente com os personagens e então enviar o resultado em uma espécie de streaming. Neste caso em específico nem o supercomputador mais rapido do mundo irá suportar o Miitopia da Meta. (CPU e GPU da Meta em 100%)

Parcialmente no servidor

O servidor envia os elementos em 3D para uso futuro (devido a grandes combinações de elementos para criar um personagem, sua memória interna vai pro beleléu).

Então, o dispositivo do usuário faz o processamento dos movimentos previamente, para então enviar pequenas informações em um aglomerado de numeros semi-precisos por meio de uma IA (Queda drástica de performance em smartphones).

Como se já não bastasse o sofrimento, a sua máquina vai ter que montar o ambiente 3D com os elementos na tela.

Custoso, mas a dor irá se ampliar mais ainda se estivermos falando de mais de duas pessoas no mesmo ambiente. É AI QUE VEM O PULO DO GATO: Imagine 100, 200 ou até 1000 pessoas no mesmo ambiente. É disso que a Intel está falando. (RIP memória interna. 3FPS de video)

Há problemas a serem resolvidos primeiros (e muitos)!

Pense naquela videochamada que você vai fazer no Zoom em sua aula EaD. Agora pense que em sua sala há cerca de 500 pessoas, todas escutando o professor. Tente chutar o numero de pessoas com atraso no audio ou problemas de conexão. É grande!

Se no metaverso houver esse problema, é bem possível que em 200Mb (25MB) de internet não suprirão as necessidades. Principalmente em um ambiente com crianças envolvidas! E mais, problemas de conexão poderão causar uma falha na renderização de chunks. Se você não entendeu, eis aqui uma foto:

O metaverso não é nenhum GTA 5, mas acredito que isso vá acontecer. Primeiro porque esse evento acontece em jogos onde o mapa é guardado localmente. Agora imagine um lugar com várias possibilidades de mapas que vão ser enviados a você por meio da internet.

Outros problemas incluem, os sombreadores, a integração com realidade estendida e as possibilidades que podem ser feitas. Infelizmente não irei citar pois o texto está imenso!

Mas, com base nestes 3 tópicos, eu faço uma pergunta a vocês para cada uma delas:

O que é um metaverso para você e como você acha que a Meta irá vencer suas expectativas?

Como você acha que a Meta irá contornar a carga gigantesca de seus servidores?

Quais outros problemas você também encontrou e precisam ser resolvidos antes do metaverso?